Pengelola harus lebih proaktif dalam mendeteksi penyalahgunaan platform. Moderasi konten pada grup-grup yang ada media sosial perlu ditingkatkan agar tak ada penyalahgunaan konten.

KOMPAS/SATRIO PANGARSO WISANGGENI—Konten-konten yang ada pada grup bertema anak korban kekerasan di Facebook.

KOMPAS/SATRIO PANGARSO WISANGGENI—Konten-konten yang ada pada grup bertema anak korban kekerasan di Facebook.

Moderasi konten yang lebih luas dan lebih intensif dinilai perlu menjadi langkah yang diambil platform media sosial untuk mencegah eksploitasi anak. Pengelola harus lebih proaktif dalam mendeteksi penyalahgunaan platform.

ADVERTISEMENT

SCROLL TO RESUME CONTENT

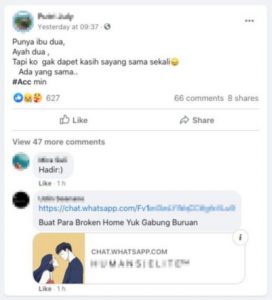

Penelusuran Liputan Khusus Kompas mengenai kekerasan terhadap anak yang dimuat pada Senin (20/7/2020) hari ini menemukan bahwa platform media sosial, seperti Facebook dan aplikasi pesan instan Whatsapp, menjadi tempat pelarian para anak-anak yang menjadi korban kekerasan. Di sana mereka menemukan kawan-kawan senasib sepenanggungan.

Namun, dalam grup malah ditemukan berbagai cerita kekerasan anak dan bunuh diri. Komentar yang disampaikan pun terkadang cenderung memuat pesan, seperti bunuh diri dan menyakiti diri sendiri (self-harm).

Kata-kata yang kasar di grup Whatsapp ”All About Broken Home”. Grup yang seharusnya menjadi tempat anak-anak yang mengalami kekerasan rumah tangga ini malah diisi dengan percakapan kata-kata yang kasar.

Para anggota yang sebagian besar masih pelajar justru saling memberikan nomor Whatsapp. Kerentanan psikis ini dapat dimanfaatkan orang asing untuk mengontak para korban dan mengeksploitasinya lebih lanjut. Dalam grup Whatsapp yang undangannya disebar di Facebook tersebut malah banyak digunakan untuk membagikan konten pornografi (Kompas, 20/7/2020).

Pakar budaya digital Fakultas Ilmu Sosial dan Ilmu Politik Universitas Indonesia (FISIP UI), Firman Kurniawan, Senin, mengatakan, peran dan tanggung jawab pengembang dapat dikaji lebih lanjut mengenai penyalahgunaan platform tersebut.

KOMPAS/SATRIO PANGARSO WISANGGENI—Konten-konten yang ada pada grup bertema anak korban kekerasan di Facebook.

KOMPAS/SATRIO PANGARSO WISANGGENI—Konten-konten yang ada pada grup bertema anak korban kekerasan di Facebook.

Selama ini, menurut Firman, ketika terjadi penyimpangan penggunaan media digital, tanggung jawab penyalahgunaan cenderung dilimpahkan ke pengguna melalui persoalan literasi digital.

”Memang ketika terjadi penyimpangan perkembangan penggunaan media digital, kemudian yang ditengok adalah literasi penggunannya. Namun, pada banyak kasus, literasi tidak ada korelasinya, tetapi tetap terjadi penggunaan yang merugikan. Di sinilah peran pengembang platform bisa dilihat lagi,” kata Firman saat dihubungi dari Jakarta.

Firman mengatakan, pengembang tidak dapat berhenti menganggap produk yang dikembangkannya sudah final dan sempurna. Ia meminta platform bersikap lebih proaktif untuk mendengarkan dan memenuhi apa yang menjadi kebutuhan perlindungan masyarakat.

Moderator konten lebih banyak

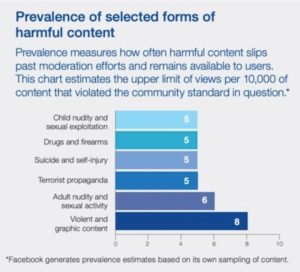

Aktivitas moderasi konten yang lebih intensif dinilai menjadi salah satu jalan menuju ruang publik yang lebih aman bagi pengguna platform. Sayangnya, proses moderasi konten oleh Facebook, khususnya di negara-negara berkembang seperti Indonesia, dinilai masih kurang dibanding apa yang dilakukan di negara Barat.

Hal ini disampaikan Deputy Director dari Pusat Studi Stern Mengenai Bisnis dan Hak Asasi Manusia (Stern Center for Business and Human Rights) New York University (NYU) Amerika Serikat Paul Barrett dalam sebuah seminar daring yang digelar NYU beberapa pekan lalu.

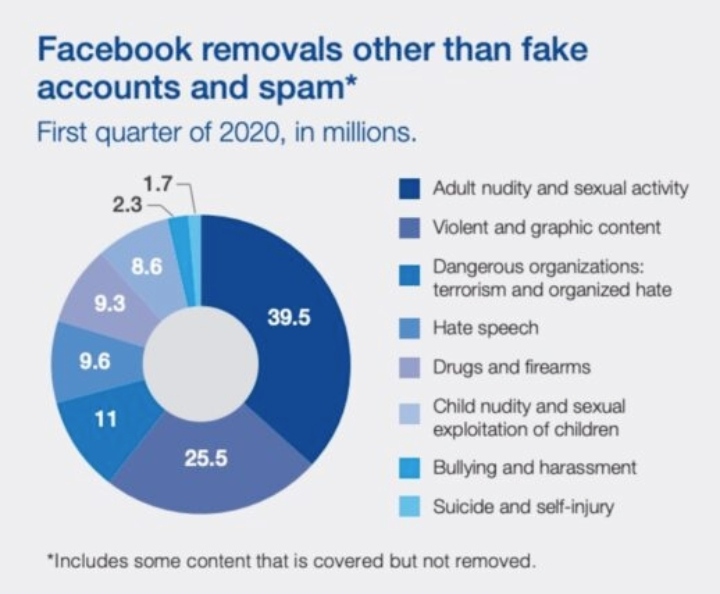

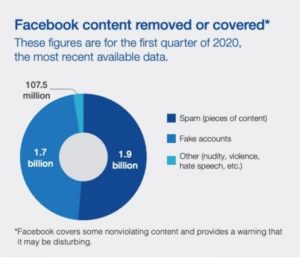

PAUL BARRETT/STERN CENTER FOR BUSINESS AND HUMAN RIGHTS NYU—Jenis konten yang dihapus Facebook dikutip dari laporan berjudul ”Who Moderates the Social Media Giants?” yang dipublikasikan Juni 2020 karya Paul Barrett, Deputi Direktur dari Stern Center for Business and Human Rights New York University (NYU).

PAUL BARRETT/STERN CENTER FOR BUSINESS AND HUMAN RIGHTS NYU—Jenis konten yang dihapus Facebook dikutip dari laporan berjudul ”Who Moderates the Social Media Giants?” yang dipublikasikan Juni 2020 karya Paul Barrett, Deputi Direktur dari Stern Center for Business and Human Rights New York University (NYU).

Pada Juni 2020, Barrett menerbitkan laporan mendalam mengenai moderasi konten yang dilakukan oleh Facebook dengan mewawancarai konten moderator hingga VP Global Policy Management Facebook Monika Bickert.

Barrett memahami bahwa dalam tiga tahun terakhir Facebook sudah menambah tiga kali lipat jumlah moderator. Namun, hal ini masih kurang. Secara umum, ia mengatakan bahwa sebaiknya Facebook menggandakan jumlah moderator kontennya dari jumlah saat ini, yakni 30.000 orang.

Penambahan ini juga perlu dikonsentrasikan pada negara-negara yang selama ini kurang mendapat perhatian yang memadai meski jumlah penggunanya besar. Kebijakan ini pun sebetulnya susah diawasi publik karena Facebook enggan memublikasikan data yang mendetail tentang jumlah moderator konten di setiap bahasa.

”Moderasi konten perlu diperluas di negara-negara berkembang, seperti Myanmar, Sri Lanka, India, Indonesia, dan Ethiopia. Ini negara-negara di mana Facebook sangat populer, tetapi jumlah moderator kontennya masih belum mencukupi,” kata Barrett.

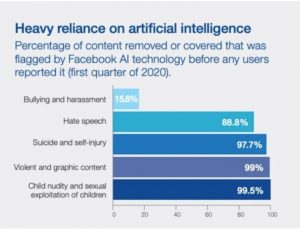

PAUL BARRETT/STERN CENTER FOR BUSINESS AND HUMAN RIGHTS NYU—Proporsi konten melanggar yang ditangani teknologi kecerdasan buatan oleh Facebook dikutip dari laporan berjudul ” Who Moderates the Social Media Giants?”.

PAUL BARRETT/STERN CENTER FOR BUSINESS AND HUMAN RIGHTS NYU—Proporsi konten melanggar yang ditangani teknologi kecerdasan buatan oleh Facebook dikutip dari laporan berjudul ” Who Moderates the Social Media Giants?”.

Secara khusus, Barrett memahami bahwa Facebook sudah berada di jalur yang tepat di Indonesia. Hal ini sudah diwujudkan dengan penambahan jumlah moderator konten dan penciptaan teknologi deteksi ujaran kebencian berbahasa Indonesia.

Barret memahami bahwa merekrut konten moderator adalah pengeluaran yang besar bagi Facebook. Namun, menurut dia, moderasi konten adalah hal yang krusial pada model bisnis Facebook yang menjual kanal iklan kepada jumlah warganet terbesar di dunia; 2,5 miliar akun.

”Tanpa moderasi konten, situs Anda akan penuh berisi konten yang berbahaya seperti kekerasan, ujaran kebencian, dan eksploitasi anak. Pengguna akan meninggalkan Anda bersama dengan perusahaan pemasang iklan yang mengikutinya,” kata Barrett.

Facebook

Menanggapi temuan liputan khusus Kompas, Kepala Kebijakan Publik untuk Indonesia Facebook Ruben Hattari memastikan bahwa Facebook memiliki kepedulian terhadap keselamatan dan kesejahteraan anak-anak remaja dan mengerahkan sumber daya yang signifikan untuk memastikan platformnya memberikan pengalaman yang aman dan positif.

”Jika orang-orang menemukan sesuatu di Facebook yang melanggar standar komunitas kami, mereka harus segera melaporkannya kepada kami,” kata Hattari melalui keterangan tertulis.

PAUL BARRETT/STERN CENTER FOR BUSINESS AND HUMAN RIGHTS NYU—Jumlah konten yang dihapus dalam kuartal pertama 2020 oleh Facebook dikutip dari laporan berjudul ”Who Moderates the Social Media Giants?” yang dipublikasikan Juni 2020 karya Paul Barrett, Deputi Direktur dari Stern Center for Business and Human Rights New York University (NYU).

PAUL BARRETT/STERN CENTER FOR BUSINESS AND HUMAN RIGHTS NYU—Jumlah konten yang dihapus dalam kuartal pertama 2020 oleh Facebook dikutip dari laporan berjudul ”Who Moderates the Social Media Giants?” yang dipublikasikan Juni 2020 karya Paul Barrett, Deputi Direktur dari Stern Center for Business and Human Rights New York University (NYU).

Facebook mengklaim jumlah orang yang bekerja di bagian keselamatan dan keamanan global adalah 35.000 orang, di mana 15.000 orang mengawasi di 50 bahasa selama 24 jam sepekan.

Khusus kepada pengguna anak-anak dan remaja, Facebook sudah melakukan kebijakan khusus, seperti membatasi kategori iklan, opsi default untuk pemirsa adalah bukan publik, dan mematikan fungsi pengenalan wajah.

Sistem teknologi pencegahan proaktif juga telah berhasil menjaring 99 persen konten berisi kekerasan, akun palsu, spam, pornografi, teroris, dan konten menyakiti diri sendiri.

PAUL BARRETT/STERN CENTER FOR BUSINESS AND HUMAN RIGHTS NYU—Jumlah konten yang melanggar per 10.000 konten (prevalensi) berdasarkan data Facebook dikutip dari laporan berjudul ” Who Moderates the Social Media Giants?” yang dipublikasikan Juni 2020 karya Paul Barrett, Deputi Direktur dari Stern Center for Business and Human Rights New York University (NYU).

PAUL BARRETT/STERN CENTER FOR BUSINESS AND HUMAN RIGHTS NYU—Jumlah konten yang melanggar per 10.000 konten (prevalensi) berdasarkan data Facebook dikutip dari laporan berjudul ” Who Moderates the Social Media Giants?” yang dipublikasikan Juni 2020 karya Paul Barrett, Deputi Direktur dari Stern Center for Business and Human Rights New York University (NYU).

”Laporan komunitas dan sistem deteksi proaktif membuat kami menjadi lebih efektif untuk mengidentifikasi dan menghapus kontan yang melanggar platform guna menjaga komunitas tetap aman,” kata Ruben.

Facebook juga mengadakan sejumlah program dan kampanye yang digunakan untuk meningkatkan literasi digital dan siber di Indonesia, seperti ”Asah Digital” pada 2019 dan ”Think Before You Share” sejak 2016.

Kedua program ini bertujuan membiasakan pengguna dan anak-anak untuk berperilaku yang baik di internet dan kritis terhadap informasi yang beredar di media sosial.

Oleh SATRIO PANGARSO WISANGGENI

Editor KHAERUDIN KHAERUDIN

Sumber: Kompas, 20 Juli 2020